С того дня, когда 21 декабря 2016 года 5-я Обзорная конференция Конвенции по «негуманному» оружию (КНО) приняла решение сформировать Группу правительственных экспертов (ГПЭ) с полномочиями «изучить и согласовать возможные рекомендации в отношении вариантов, связанных с новыми технологиями в области смертоносных автономных систем (САС)», военные технологии сделали несколько шагов по пути, на котором человек может быть практически исключен из процесса принятия решений на поле боя. Необходимо разработать механизм, который позволит обеспечить соблюдение норм международного гуманитарного права (МГП) перспективными боевыми системами – боевыми роботами и системами управления на основе искусственного интеллекта.

Человек, как элемент «военного интернета вещей»

Развертывание «военного интернета вещей» (Internet of Military Things (IoMT)) подразумевает разработку и принятие на вооружение сети датчиков, носимых и прочих устройств, которые превратятся в элементы сетецентрической архитектуры с использованием технологии связи 5G, облачных хранилищ и вычислительных устройств.

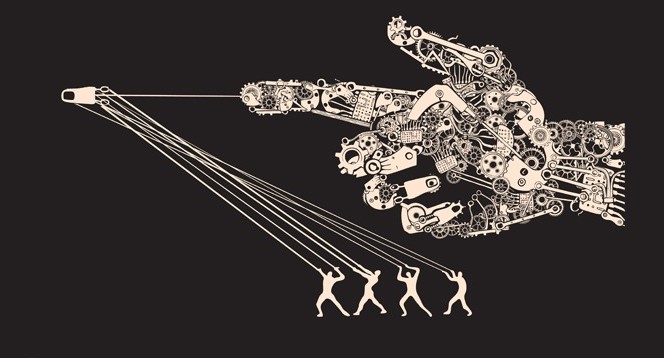

Основными генераторами и получателями сообщений станут не люди, а «вещи», количество которых будет исчисляться миллионами. Датчики будут обмениваться информацией между собой и на основе алгоритмов ИИ принимать решения о необходимости определенных действий: зарядке аккумулятора, смене позиции, доставке боеприпасов и комплектующих и пр. Человек будет включен в информационную сеть, но по сути он будет представлять собой одну из «интеллектуальных вещей». Некоторые решения будут приниматься без его участия, причем количество таких решений будет возрастать по мере увеличения способностей ИИ-алгоритмов.

На каком-то этапе возникнет ситуация, когда роль человека будет сведена к минимуму, и «интеллектуальные вещи» (компоненты IoMT) будут противоборствовать непосредственно с «интеллектуальными вещами» противника. Человек будет только направлять их действия на уровне намерений. Логика технического прогресса ведет к полной автономности IoMT [2].

Но не надо думать, что полная автономность боевых машин наступит нескоро. Уже сегодня некоторые технические причины заставляют военные ведомства сомневаться в самой возможности не только запрета, но и регулирования САС:

- Испытания дистанционно управляемых наземных роботов показали, что эффективная дальность радиосвязи с оператором не превышает 2-5 км. В автономном режиме наземный робот будет способен действовать на удалении до 500 км. Ограниченная радиосвязь заставляет военных разрабатывать абсолютно автономные режимы использования САС.

- Современные боевые действия предусматривают активное применение средств радиоэлектронной борьбы для подавления или изменения качества управления, связи и разведки противника. У разработчиков нет универсального ответа на вопрос, что делать с дистанционно управляемым боевым роботом, потерявшим связь. С точки зрения военных, автономный режим должен быть предусмотрен, по крайней мере, «на крайний случай».

Можно ли добиться, чтобы перспективные военные системы действовали с соблюдением международного гуманитарного права, оставались подконтрольны человеку и сохраняли возможность определить ответственного за их действия?

Проверить алгеброй гармонию

В 2019 году ГПЭ согласовала 11 руководящих принципов относительно САС [1], которые, среди прочего, подтверждали, что ответственность человека за решения о применении оружейных систем должна быть сохранена, а взаимодействие человека и машины должно осуществляться в соответствии с нормами международного гуманитарного права.

Инициативная группа государств и неправительственных организаций настаивает на принятии полного превентивного международного запрета САС. Один из главных аргументов сторонников полного запрета состоит в том, что автономные вооружения будут не в состоянии соблюдать положения МГП: то есть не смогут различать комбатантов и гражданских лиц, не сумеют верно оценить угрозу и соизмерить силу ответного удара, станут причинять ущерб гражданским объектами и гражданскому населению.

Некоторые страны в КНО, в том числе Россия, придерживаются иной точки зрения и видят в автономных системах потенциал для более точного соблюдения международного гуманитарного права на фоне психологических проблем, которые испытывает на поле боя человек.

МГП требует, чтобы ответственные за использование систем вооружений с искусственным интеллектом, принимали необходимые меры предосторожности для предотвращения или сведения к минимуму случайных жертв среди гражданского населения и ущерба гражданскому имуществу. Эти меры, в частности, могут включать ограничение военной операции по территории, категориям целей, критериям распознавания людей, применяемым средствам поражения.

То есть военные должны обладать конкретными навыками:

- распознание образов

- способность отличить военных от гражданских лиц, военные объекты от гражданских

- знание технических характеристик собственных вооружений

- знание возможностей противника, умение просчитать эффективность его ответных действий

- способность рассчитать минимальные силы и средства, необходимые для достижения военных целей

- умение определить способ нанесения минимального ущерба гражданским лицам и объектам при выполнении боевой задачи.

Для этого командиры должны располагать широкими знаниями, значительными аналитическими навыками и арифметическими способностями, иными словами: обширной базой данных, высокой вычислительной мощностью и способностью к обработке «больших данных». То есть международное законодательство требует от военачальников качеств, свойственных нейронным сетям и искусственному интеллекту. Сам принцип соразмерности (или в английском варианте – proportionality) указывает на математическую основу правил ведения войны.

В фильме 2015 года «Eye in the Sky» процесс принятия человеком решения на поражение с использованием дрона показан достаточно подробно. Фактически он сводился к математическим расчетам и спорам по поводу приемлемого «побочного ущерба» (невинных жертвах).

И если однажды подобные решения будут переложены на «плечи» ИИ, следует сделать так, чтобы искусственный интеллект поступал гуманнее человека. Например, среди приоритетных ценностей, заложенных в электронном мозгу, должно числиться человеческое достоинство. Как реализовать их в идеальном будущем? Как вариант – через использование нелетального оружия.

Уроки конфликта в Нагорном Карабахе

В реальных военных действиях «человеческий фактор» проявляет себя не лучшим образом. Как отметил в своем интервью «Интерфаксу» Президент Международного комитета Красного Креста Петер Маурер: «Я не видел за восемь лет во главе МККК, и организация не видела за 157 лет существования, войны, которая бы не сопровождалась нарушениями Женевских конвенций и международного гуманитарного права» [3].

Многочисленные нарушения были зафиксированы в ходе военного конфликта в Нагорном Карабахе в конце 2020 года. Факты, запротоколированные организациями МККК, Amnesty International, Human Rights Watch, Halo Trust и Factcheck.kz, указывают, что нарушения международного гуманитарного права в конфликте осуществлялись с использованием тяжелой артиллерии, РСЗО, кассетных боеприпасов, авиационных бомб и баллистических ракет [4].

При этом в докладах нет ни одного упоминания использования беспилотных вооружений в нарушение МГП.

Беспилотные системы (следует признать, что не полностью автономные) не просто продемонстрировали способность выполнить боевую задачу с соблюдением МГП, но практически в эфире продемонстрировали наличие контроля со стороны человека, а также потенциальную возможность атрибуции (идентификации) ответственного за нанесенный ущерб.

Статья 21 Конституции Российской Федерации гласит: «Достоинство личности охраняется государством. Ничто не может быть основанием для его умаления. Никто не должен подвергаться пыткам, насилию, другому жестокому или унижающему человеческое достоинство обращению или наказанию» [5].

Ценность человеческого достоинства остается весомым аргументом в пользу запрета или строгого ограничения САС. Но если человечество не сумеет проявить единодушие в регулировании автономных систем, необходимо обучить военные ИИ-системы соблюдать МГП надежнее, чем это делают люди.

Список источников:

- Доклад сессии 2019 года Группы правительственных экспертов по вопросам, касающимся новых технологий в сфере создания смертоносных автономных систем вооружений, Группа правительственных экспертов по вопросам, касающимся новых технологий в сфере создания смертоносных автономных систем вооружений, Женева, 25‒29 марта 2019 года и 20‒21 августа 2019 г. [Электронный ресурс] // URL: https://undocs.org/pdf?symbol=ru/CCW/GGE.1/2019/3 (дата обращения: 27.06.2021)

- По результатам конференции Internet of Battlefield Things, Defense IQ, 3 марта 2021 г.

- Президент МККК: гуманитарный кризис в Нагорном Карабахе длится уже 28 лет, Интерфакс, 17 ноября 2020 г. [Электронный ресурс] // URL: https://www.interfax.ru/interview/737420 (дата обращения: 27.06.2021)

- Станет ли дрон гуманнее человека, Вадим Козюлин, НВО, 01 апреля 2021 г. [Электронный ресурс] // URL: https://nvo.ng.ru/concepts/2021-04-01/6_1135_drone.html?print=Y (дата обращения: 27.06.2021)

- “Конституция Российской Федерации” (принята всенародным голосованием 12.12.1993 с изменениями, одобренными в ходе общероссийского голосования 01.07.2020), Статья 21, [Электронный ресурс] // URL: http://www.consultant.ru/document/cons_doc_LAW_28399/e7fbd40d5c89c3066eab2473bcaac30880b58eb3/ (дата обращения: 21.11.2021)